如何进行大模型多模态微调 问题浅析

1.1 问题浅析

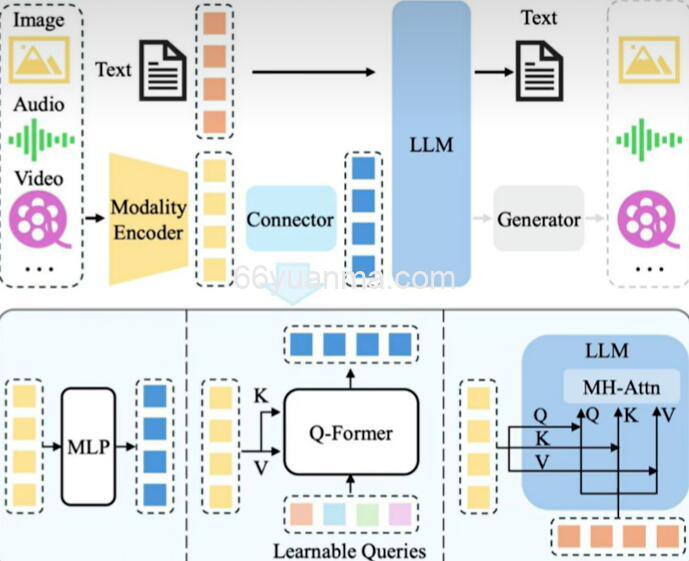

多模态大模型的核心架构可概括为 “视觉编码器 + 投影层 + 语言模型” 的三段式结构,三者各司其职又紧密联动:

- 视觉编码器:负责将图像、视频等视觉信息转化为计算机可处理的高维特征向量(如使用 ViT、Swin Transformer 等经典视觉模型);

- 投影层:作为连接视觉与语言的 “桥梁”,将高维视觉向量压缩、转换为语言模型能识别的 Token 格式,实现跨模态特征的初步对齐;

- 语言模型:基于对齐后的视觉 Token 与文本 Token,完成理解(如图文问答)或生成(如影像报告撰写)任务。

在这一架构中,投影层是多模态微调的 “关键突破口”。尽管其参数量通常仅占模型总量的 1%-5%,但它直接决定了视觉特征向语言空间转化的精度 —— 若投影层无法精准匹配下游任务的特征需求,即便视觉编码器和语言模型性能再强,也会出现 “图文错位” 的问题(例如医疗影像中漏检病灶特征、图表解析中误读数据逻辑)。

1.2 标准答案

多模态微调的核心思路是 “优先调优关键组件,按需扩展微调范围”,具体可分为两个层级:

第一层级:仅微调投影层(基础方案)

这是最常用、性价比最高的微调方式。原理是:冻结预训练好的视觉编码器(避免其丢失通用视觉特征提取能力)和语言模型(防止破坏其语言理解与生成基础),仅对投影层进行全量重训练。

之所以优先选择投影层,是因为预训练阶段的投影层是为 “通用场景” 设计的(如识别日常物体、描述风景),而下游任务往往有明确的领域属性 —— 比如医疗场景需要投影层重点捕捉 “病灶纹理”“器官形态” 等特征,工业检测场景则需聚焦 “零件缺陷”“设备参数” 等信息。通过重训练投影层,可让其学会将特定领域的视觉特征精准映射到语言空间,实现 “低成本、高效率” 的对齐优化。

第二层级:结合 LoRA 微调语言模型(进阶方案)

当仅微调投影层无法满足任务需求时(例如需要模型生成专业度极高的文本,如学术论文配图解读、金融财报图表分析),需进一步对语言模型进行局部微调。此时通常采用LoRA(低秩适应)或 QLORA(量化低秩适应)技术:

- 在语言模型的关键层(如 Transformer 的注意力层)插入小型 LoRA 模块,仅更新该模块的少量参数(通常占语言模型参数量的 0.1%-1%);

- 这样做既能让语言模型学习到领域专属的表达风格(如医学报告的规范术语、金融分析的专业表述),又能避免全量微调带来的 “灾难性遗忘”(即丢失通用语言能力),同时大幅降低计算资源消耗(无需占用海量 GPU 显存)。

欢迎使用66资源网

1. 本站所有资源来源于用户上传和网络,如有侵权请邮件联系站长!

2. 分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3. 不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4. 本站提供的源码、模板、插件等等其他资源,都不包含技术服务请大家谅解!

5. 如有链接无法下载、失效或广告,请联系管理员处理!

6. 如遇到加密压缩包,请使用WINRAR解压,如遇到无法解压的请联系管理员!

7. 本站有不少源码未能详细测试(解密),不能分辨部分源码是病毒还是误报,所以没有进行任何修改,大家使用前请进行甄别!

66源码网 » 如何进行大模型多模态微调 问题浅析

1. 本站所有资源来源于用户上传和网络,如有侵权请邮件联系站长!

2. 分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3. 不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4. 本站提供的源码、模板、插件等等其他资源,都不包含技术服务请大家谅解!

5. 如有链接无法下载、失效或广告,请联系管理员处理!

6. 如遇到加密压缩包,请使用WINRAR解压,如遇到无法解压的请联系管理员!

7. 本站有不少源码未能详细测试(解密),不能分辨部分源码是病毒还是误报,所以没有进行任何修改,大家使用前请进行甄别!

66源码网 » 如何进行大模型多模态微调 问题浅析