深度分析大数据领域存算分离的资源隔离机制

1. 背景介绍

1.1 目的和范围

随着企业数据量以年均40%的速度增长,传统存算一体架构在资源利用率、弹性扩展、成本控制等方面的弊端日益凸显。存算分离通过将计算与存储解耦,实现两类资源的独立扩容与优化配置,已成为大数据平台架构演进的主流方向。然而,多租户环境下的资源抢占、性能干扰、数据安全等问题,使资源隔离机制成为决定存算分离架构成败的关键因素。

本文聚焦以下核心问题:

存算分离架构中资源隔离的分层模型与技术体系

计算资源、存储资源、元数据资源的隔离实现机制

隔离技术对系统性能、扩展性、成本的影响权衡

典型行业场景的差异化隔离方案设计

1.2 预期读者

大数据架构师:掌握存算分离架构设计的核心技术点

云计算工程师:理解多租户环境下的资源管理策略

数据平台开发者:学习具体隔离技术的工程实现方法

高校研究人员:获取资源隔离领域的技术演进路线图

1.3 文档结构概述

全文采用”原理分析→技术实现→工程实践→场景应用→未来展望”的逻辑结构:

背景篇:定义核心概念,明确技术价值与研究范围

原理篇:解析分层架构,建立隔离机制的理论模型

技术篇:详述计算、存储、元数据的隔离实现方案

实战篇:通过Spark案例演示完整的开发与调优过程

应用篇:分析典型行业的差异化隔离需求

展望篇:探讨技术趋势与未来挑战

1.4 术语表

1.4.1 核心术语定义

存算分离(Compute-Storage Separation):计算节点与存储节点在物理部署和资源管理上完全解耦,通过高速网络实现数据交互的架构模式

资源隔离(Resource Isolation):在多租户环境中,确保不同租户的计算、存储、网络资源互不干扰的技术集合

租户(Tenant):大数据平台的独立使用单元,通常对应企业内的某个部门、业务线或外部客户

弹性扩展(Elastic Scaling):根据负载动态调整计算/存储资源规模的能力,分为纵向扩展(Scale Up)和横向扩展(Scale Out)

1.4.2 相关概念解释

共享存储(Shared Storage):多个计算节点通过网络访问统一存储集群的架构,常见实现有HDFS、S3、OSS

无状态计算(Stateless Computing):计算节点不持久化存储数据,仅通过临时缓存处理任务的设计模式

资源调度(Resource Scheduling):根据业务需求动态分配CPU、内存、IO等资源的决策过程

1.4.3 缩略词列表

缩略词 全称

YARN Yet Another Resource Negotiator(Hadoop资源调度系统)

Docker Docker容器引擎

K8s Kubernetes容器编排系统

QoS Quality of Service(服务质量保障)

SLS Serverless(无服务器架构)

2. 核心概念与联系

2.1 存算分离架构分层模型

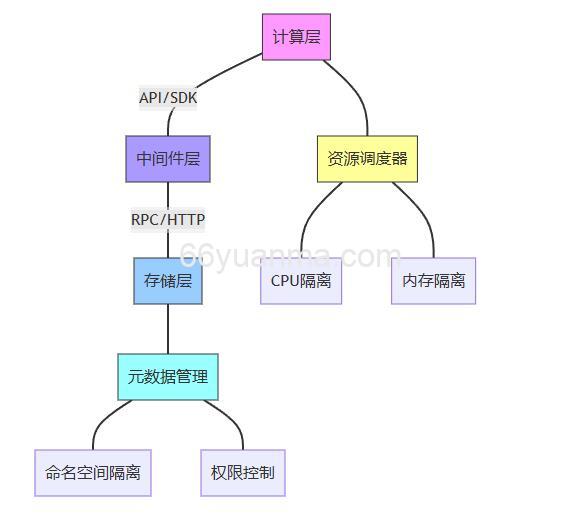

存算分离架构可分为三个核心层次,每层对资源隔离有不同需求:

2.1.1 计算层(Compute Layer)

核心组件:Spark、Flink、Hadoop YARN等计算框架

隔离需求:CPU核数、内存容量、网络带宽的细粒度分配

关键技术:容器化(Docker/Kubernetes)、虚拟化(VMware)、资源调度队列(Fair Scheduler)

2.1.2 中间件层(Middleware Layer)

核心组件:元数据服务(Hive Metastore)、数据传输服务(Sqoop)、消息队列(Kafka)

隔离需求:元数据访问权限控制、数据传输带宽限制、消息队列优先级管理

关键技术:多租户元数据存储、流量控制算法、队列分组机制

2.1.3 存储层(Storage Layer)

核心组件:分布式文件系统(HDFS)、对象存储(S3)、分布式数据库(HBase)

隔离需求:存储容量配额、IOPS限制、数据访问权限

关键技术:存储桶隔离、目录级权限控制、QoS策略配置

2.2 资源隔离核心目标

租户隔离(Tenant Isolation):确保租户A的计算任务不会占用租户B的CPU资源,租户A的数据文件不会被租户B非法访问

任务隔离(Task Isolation):不同优先级任务(如实时计算vs离线分析)的资源分配互不影响

数据隔离(Data Isolation):敏感数据的存储、传输、处理过程满足合规要求(如GDPR)

故障隔离(Fault Isolation):单个租户的任务崩溃不会导致整个集群不可用

2.3 隔离机制与架构特性的关联

架构特性 隔离技术贡献 典型实现方案

弹性扩展 按需分配资源,避免资源抢占 动态资源调度算法

高可用性 故障域隔离,错误恢复不影响其他租户 容器自愈机制(K8s)

成本优化 资源利用率提升,避免过度预留 资源配额管理系统

安全性 数据访问控制,防止越权访问 基于角色的访问控制(RBAC)

3. 核心算法原理 & 具体操作步骤

3.1 计算资源调度算法

3.1.1 公平调度算法(Fair Scheduler)

算法原理:确保每个租户在长时间运行中获得公平的资源分配,支持动态调整队列权重

class FairScheduler:

def __init__(self):

self.queues = {} # 队列字典,键为队列名称,值为队列对象

self.cluster_resources = {‘cpu’: 100, ‘memory’: 10240} # 集群总资源(单位:CPU核心数,GB)

class Queue:

def __init__(self, name, weight, min_resources, max_resources):

self.name = name

self.weight = weight # 队列权重,影响资源分配优先级

self.min_resources = min_resources # 最小资源保障

self.max_resources = max_resources # 最大资源限制

self.pending_tasks = [] # 待调度任务列表

def add_task(self, task):

self.pending_tasks.append(task)

def allocate_resources(self):

total_weight = sum(queue.weight for queue in self.queues.values())

for queue in self.queues.values():

# 计算理想分配量 = 集群资源 * (队列权重 / 总权重)

ideal_cpu = self.cluster_resources[‘cpu’] * (queue.weight / total_weight)

ideal_memory = self.cluster_resources[‘memory’] * (queue.weight / total_weight)

# 实际分配量不低于最小保障,不超过最大限制

allocated_cpu = max(queue.min_resources[‘cpu’], min(ideal_cpu, queue.max_resources[‘cpu’]))

allocated_memory = max(queue.min_resources[‘memory’], min(ideal_memory, queue.max_resources[‘memory’]))

# 调度任务到计算节点

self.schedule_tasks(queue, allocated_cpu, allocated_memory)

def schedule_tasks(self, queue, cpu, memory):

# 简化实现:按任务提交顺序分配资源

while cpu > 0 and memory > 0 and queue.pending_tasks:

task = queue.pending_tasks[0]

required_cpu = task.cpu_request

required_memory = task.memory_request

if required_cpu <= cpu and required_memory <= memory:

# 分配资源给任务

cpu -= required_cpu

memory -= required_memory

queue.pending_tasks.pop(0)

# 模拟任务执行

self.execute_task(task)

else:

break

def execute_task(self, task):

# 实际应调用计算框架API启动任务

print(f”Task {task.id} started with {task.cpu_request} CPU, {task.memory_request} MB”)

3.1.2 操作步骤

队列定义:为每个租户创建独立队列,配置权重(如核心业务队列权重5,测试队列权重1)

资源限额:设置队列最小/最大资源占用(如最小保障20% CPU,最大限制40% CPU)

任务提交:租户任务进入所属队列,按FIFO或优先级排序

周期性调度:调度器每500ms执行一次资源分配算法(见上述代码)

动态调整:根据队列负载实时调整权重(如通过YARN的REST API动态修改队列参数)

3.2 存储资源隔离技术

3.2.1 基于存储桶的隔离方案

实现原理:在对象存储系统中为每个租户创建独立存储桶,通过访问策略限制跨桶访问

流量控制:通过S3的存储类(如Standard、Infrequent Access)实现成本隔离

监控告警:设置存储容量阈值(如超过10TB触发扩容通知)

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 资源分配优化模型

问题定义:在多租户环境中,如何分配CPU资源使所有租户的延迟敏感任务满足SLA要求

符号定义:

( n ):租户数量

( C ):集群总CPU核心数

( c_i ):租户i的CPU分配量(( \sum_{i=1}^n c_i \leq C ))

( w_i ):租户i的任务权重(反映业务优先级)

( D_i ):租户i的任务延迟目标

( d_i ):租户i的实际任务延迟(与CPU分配成反比)

目标函数:最小化最大延迟违反率

[

\min \max_{i=1}^n \left( \frac{d_i – D_i}{D_i} \right)^+

]

约束条件:

资源总量约束:( \sum_{i=1}^n c_i \leq C )

最小资源保障:( c_i \geq c_{min,i} )(如租户i至少分配2个核心)

延迟模型:( d_i = \frac{k_i}{c_i} )(k_i为租户i的任务计算复杂度)

4.2 求解方法

采用拉格朗日乘数法求解带约束的优化问题,构造拉格朗日函数:

[

\mathcal{L} = \lambda \left( C – \sum_{i=1}^n c_i \right) + \sum_{i=1}^n \mu_i (c_i – c_{min,i}) + \sum_{i=1}^n \frac{k_i}{c_i}

]

对( c_i )求偏导并令其为零:

[

\frac{\partial \mathcal{L}}{\partial c_i} = -\lambda + \mu_i – \frac{k_i}{c_i^2} = 0

]

解得最优分配:

[

c_i = \sqrt{\frac{k_i}{\lambda – \mu_i}}

]

其中(\lambda)和(\mu_i)通过KKT条件确定边界情况(是否达到最小资源限制)

4.3 举例说明

场景:2个租户,总CPU核心数8,租户1最小保障2核,租户2最小保障1核

任务复杂度:( k_1=100, k_2=50 )

目标延迟:( D_1=100ms, D_2=200ms )

求解过程:

不考虑最小保障时,最优解需满足( c_1 + c_2 = 8 ),且( \sqrt{100/\lambda} + \sqrt{50/\lambda} = 8 ),解得(\lambda=1.17),(c_1=9.25)(超过总资源,不可行)

考虑租户1最小保障2核,分配(c_1=2),剩余6核分配给租户2,此时(d_1=100/2=50ms < D_1),(d_2=50/6≈8.3ms < D_2),满足SLA要求

1. 本站所有资源来源于用户上传和网络,如有侵权请邮件联系站长!

2. 分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3. 不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4. 本站提供的源码、模板、插件等等其他资源,都不包含技术服务请大家谅解!

5. 如有链接无法下载、失效或广告,请联系管理员处理!

6. 如遇到加密压缩包,请使用WINRAR解压,如遇到无法解压的请联系管理员!

7. 本站有不少源码未能详细测试(解密),不能分辨部分源码是病毒还是误报,所以没有进行任何修改,大家使用前请进行甄别!

66源码网 » 深度分析大数据领域存算分离的资源隔离机制