Flink-Connector 未来发展规划应用场景

接下来,分享下 StarRocks 在实时数据分析方面,会进一步做出哪些工作。

一方面从易用性角度,支持主键与排序键分离。在目前的主键模型中,可以认为 Sort Key 和 Primary Key 是统一在一起的。例如右边的例子,主键是 id。如果数据按照 id 排序,对 City 过滤的查询,就需要扫描全表,或者需要加其它二级索引,想办法加速过滤。

如果能把 Sort Key 和 Primary 拆分开,建表时可以让 Sort Key 和 Primary 用不同的字段。比如 id 作为主键,负责更新的唯一约束;City 作为 Sort Key,负责数据的存储顺序。这样就能加速一些常见的查询。

其实可以进一步思考,目前 StarRocks 的好几种表模型,duplicate/aggr/unique 面对不同场合,客户需要稍作选择。这些都可以统一到一种语法表达,统一之后,对用户来说,只有一种表更容易理解,可以进一步提升易用性。

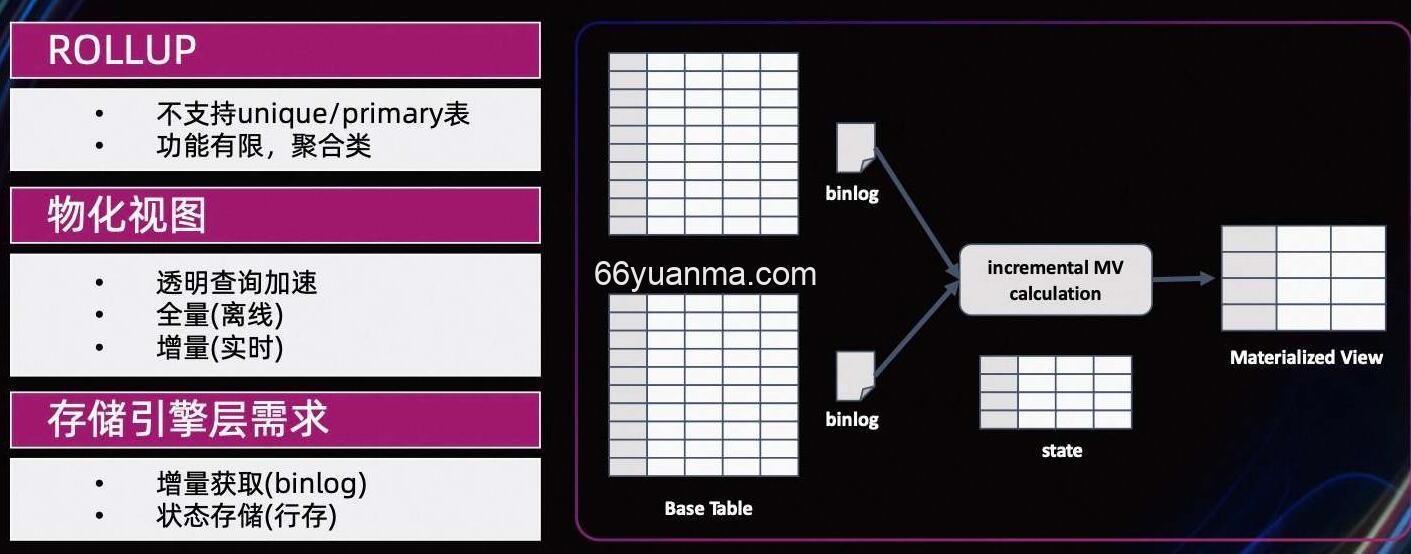

另一个重要的方向是。多表物化视图。目前,主键模型并不支持 ROLLUP 和物化视图,而 ROLLUP 功能也比较有限。StarRocks 新一代的多表物化视图架构会支持更加高级的功能,包括透明的查询加速,离线的全量构建和实时的增量构建;可以写比较复杂的表达式,多表关联,子查询嵌套等等;以类似 Insert into overwrtie 的语义异步或者同步的自动完成物化。

增量物化视图的构建,需要能够提供表的增量修改数据。我们会在内部实现类似 binlog 的机制,来辅助实时增量多表物化的任务。

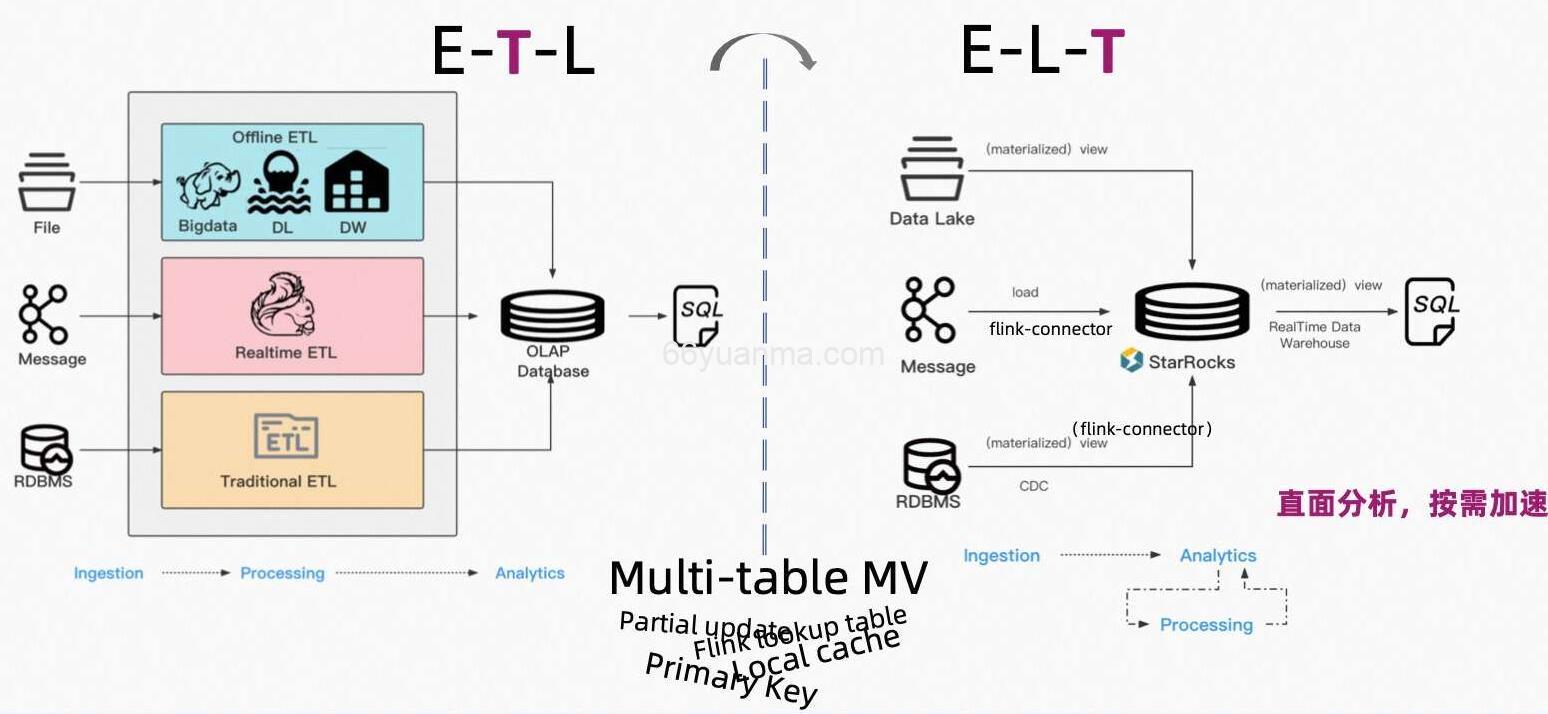

有了增量多表物化视图,更易用,性能又更好的 Primary Key 模型,乃至于部分列更新,LocalCache 加速等 Feature 的加持。未来实时数据分析或将迎来新的范式。人们不必再设计非常复杂的 ETL 架构,维护那么多的外围程序,做了很多无效的数据搬运工作,耗费了不少人力和物力,交付节奏总跟不上新需求迸发的速度。

未来,你有可能通过 Flink,将实时数据从消息队列或者 TP 的 CDC 秒级的持续稳定的摄入进 StarRocks。在 StarRocks 里,直接去面向分析,开发我们的指标和模型。外表的形式也好,逻辑视图也好,CTE 也好,以最敏捷的形式快速迭代开发。开发完 SQL 逻辑之后,结合场景,哪些指标是需要高并发低延迟的服务的?哪些层是需要反复被其它下游频繁调用的?不管是宽表,还是多表关联的复杂 SQL,我们都可以按需的去上卷或构建物化。直面分析,按需加速,让数据分析的链路更经济,效率更好。

实时即未来,StarRocks 在逐渐实现这样的能力,StarRocks 和 Flink 结合去构建实时数据分析体系的联合解决方案,将在一定程度上颠覆既有的一些禁锢,形成实时数据分析新范式。

1. 本站所有资源来源于用户上传和网络,如有侵权请邮件联系站长!

2. 分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3. 不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4. 本站提供的源码、模板、插件等等其他资源,都不包含技术服务请大家谅解!

5. 如有链接无法下载、失效或广告,请联系管理员处理!

6. 如遇到加密压缩包,请使用WINRAR解压,如遇到无法解压的请联系管理员!

7. 本站有不少源码未能详细测试(解密),不能分辨部分源码是病毒还是误报,所以没有进行任何修改,大家使用前请进行甄别!

66源码网 » Flink-Connector 未来发展规划应用场景